Pernahkah Anda terpukau dengan kecepatan kilat yang dimiliki sebuah komputer dalam menyelesaikan tugas-tugas rumit? Saat kita mengetikkan perintah sederhana atau menjalankan aplikasi berat, komputer mampu memproses dan mengeksekusi semuanya hampir seketika. Namun, ada rahasia menarik yang bekerja di balik layar—menyibak bagaimana komputer membaca dan mengeksekusi perintah hingga mencapai tingkat efisiensi yang mengagumkan.

Dalam dunia komputasi, kemampuan ini bukanlah sihir, melainkan hasil dari sistem kompleks yang terdiri atas berbagai komponen elektronik dan algoritma canggih. Di setiap detik waktu kita habiskan berselancar di dunia maya atau menyelesaikan pekerjaan digital, komputer menjalankan serangkaian instruksi yang diubah menjadi bahasa mesin, lalu diterjemahkan kembali menjadi respons yang kita pahami. Mari kita telusuri lebih dalam bagaimana proses ini berlangsung, serta faktor-faktor yang membuatnya begitu cepat dan akurat, membawa kita ke era teknologi yang menakjubkan.

Pengantar Sistem Komputer dan Proses Eksekusi Perintah

Sebelum kita memahami rincian teknis, penting untuk mengetahui landasan dasar sistem komputer. Pada dasarnya, setiap komputer terdiri atas perangkat keras (hardware) dan perangkat lunak (software). Hardware mencakup CPU, memori, dan perangkat input/output, sedangkan software adalah kumpulan instruksi atau program yang memerintah hardware untuk melakukan tugas tertentu. Proses eksekusi perintah dimulai saat pengguna atau aplikasi mengirimkan instruksi ke sistem operasi, yang kemudian meneruskan barisan perintah tersebut ke CPU untuk diproses lebih lanjut.

Pertanyaan utama yang sering muncul adalah, “Bagaimana komputer membaca dan mengeksekusi perintah?” Prosedurnya melibatkan ciclos fetch-decode-execute: CPU mengambil (fetch) instruksi dari memori, menerjemahkannya (decode) menjadi sinyal kontrol, lalu menjalankan (execute) operasi yang sesuai. Semuanya dikoordinasikan oleh unit pengendali (control unit) di dalam CPU. Proses ini berulang jutaan hingga miliaran kali per detik, memungkinkan komputer menjalankan aplikasi kompleks dan multitasking dengan kecepatan luar biasa.

Pengantar sistem komputer ini membangun fondasi pemahaman sebelum kita menyelami bagaimana instruksi diubah menjadi rangkaian sinyal elektronik, bagaimana memori dan cache bekerja sama, serta bagaimana optimasi dan prediksi percabangan memaksimalkan kecepatan eksekusi. Dengan memahami alur dasar ini, kita dapat menghargai kecanggihan teknologi yang tak kasat mata namun sangat menentukan kinerja komputer sehari-hari.

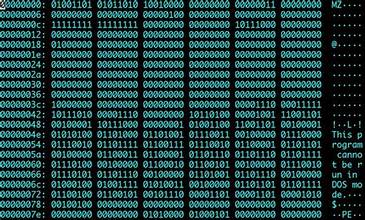

Konsep Dasar Bahasa Mesin dan Penterjemahan Perintah

Pada lapisan paling rendah, komputer hanya memahami bilangan biner—rangkaian 0 dan 1 yang mewakili sinyal listrik mati atau hidup. Bahasa mesin (machine language) adalah kumpulan instruksi paling dasar dalam format biner ini. Setiap instruksi mengandung opcode (operasi) dan operand (data atau alamat memori). Sebagai contoh, instruksi 10110000 bisa berarti “pindahkan data ke register tertentu,” tergantung arsitektur CPU yang digunakan.

Untuk memudahkan pengembangan perangkat lunak, programmer jarang menulis kode langsung dalam bahasa mesin. Di sinilah penterjemah (translator) seperti compiler dan assembler berperan. Compiler mengubah kode sumber tingkat tinggi (seperti C, Java, atau Python) menjadi bahasa mesin secara keseluruhan sebelum eksekusi, sementara assembler menerjemahkan kode assembly—representasi simbolik dari bahasa mesin—menjadi bit biner. Ada pula interpreter yang menerjemahkan dan menjalankan instruksi satu per satu secara langsung, seperti pada Python atau JavaScript. Dengan demikian, proses penterjemahan instruksi adalah langkah krusial dalam menjawab pertanyaan Bagaimana komputer membaca dan mengeksekusi perintah? karena tanpa tahap ini, CPU tidak akan dapat memahami logika program yang ditulis manusia.

Baca Juga Mengenai : Menguasai ‘Cara Berpikir Komputasional Algoritma Loop Conditional’ Dengan Mudah

Peran CPU dalam Mengeksekusi Perintah dengan Cepat

Central Processing Unit (CPU) sering disebut otak komputer karena bertanggung jawab atas sebagian besar perhitungan dan kontrol alur instruksi. Di dalam CPU terdapat unit kontrol (control unit), Arithmetic Logic Unit (ALU), register, dan cache tingkat pertama (L1). Unit kontrol mengatur urutan fetch-decode-execute, sementara ALU melakukan operasi aritmetika dan logika. Register, sebagai memori sangat cepat, menyimpan data dan instruksi sementara yang sedang diproses. Kombinasi komponen ini memungkinkan CPU mengeksekusi instruksi dalam hitungan nanodetik.

Kecepatan eksekusi CPU diukur dalam Hertz (Hz), yang merepresentasikan jumlah siklus jam (clock cycles) per detik. CPU modern bekerja pada gigahertz (GHz), mampu melakukan miliaran siklus setiap detik. Selain itu, teknologi multi-core memungkinkan beberapa unit pemrosesan independen di dalam satu chip, meningkatkan kemampuan paralelisme. Dengan parallel processing, CPU dapat mengeksekusi banyak instruksi secara bersamaan, sangat berguna untuk aplikasi multitasking dan komputasi berat seperti rendering video atau simulasi ilmiah.

Fitur tambahan seperti hyper-threading atau simultaneous multithreading (SMT) juga memaksimalkan pemanfaatan sumber daya CPU. Dengan memunculkan beberapa thread logis per inti fisik, CPU dapat menangani beban kerja berkaitan input/output (I/O) dan kalkulasi secara lebih efisien. Oleh karena itu, sinergi antara kecepatan clock, arsitektur multi-core, dan teknik hyper-threading menjawab Bagaimana komputer membaca dan mengeksekusi perintah dengan kecepatan luar biasa.

Memahami Memori Komputer dan Peran Pentingnya

Memori komputer berfungsi menyimpan data dan instruksi yang dibutuhkan CPU. Jenis memori terbagi menjadi memori utama (Primary Memory) dan memori sekunder (Secondary Memory). RAM (Random Access Memory) adalah memori utama yang bersifat volatil—data hilang saat listrik mati—tetapi menawarkan akses cepat bagi CPU. Sebaliknya, memori sekunder seperti hard drive atau SSD menyimpan data secara permanen meski kecepatan aksesnya lebih lambat daripada RAM.

Karena perbedaan kecepatan signifikan antara CPU dan memori, hierarki memori dirancang untuk menyeimbangkan kecepatan dan kapasitas. Di puncak terdapat register CPU, lalu L1/L2/L3 cache, RAM, dan akhirnya memori sekunder. Semakin rendah levelnya, kapasitas meningkat tetapi latensi juga bertambah. CPU selalu berupaya mengambil instruksi dan data dari level tertinggi yang tersedia, meminimalkan waktu tunggu. Manajemen memori modern juga mencakup virtual memory, di mana sebagian ruang disk digunakan sebagai perluasan RAM saat beban kerja melebihi kapasitas fisik.

Memori memainkan peranan krusial dalam pertanyaan Bagaimana komputer membaca dan mengeksekusi perintah? karena proses fetch instruksi dan operand sangat bergantung pada kecepatan akses memori. Jika data berada di cache atau register, CPU dapat langsung memprosesnya. Namun, jika harus menunggu data dari RAM atau bahkan SSD, kecepatan eksekusi perintah akan melambat, memengaruhi performa sistem secara keseluruhan.

Baca Juga Mengenai : Sejarah Perkembangan Ilmu dan Teknologi di Indonesia Sebelum 1900

Penggunaan Cache Memory untuk Meningkatkan Kecepatan Eksekusi

Cache memory adalah lapisan memori cepat yang ditempatkan di antara CPU dan RAM. Tujuan utamanya adalah menyimpan data dan instruksi yang sering diakses agar CPU tidak perlu menunggu lama mengambilnya dari RAM. Terdapat beberapa level cache: L1 (paling cepat, kapasitas kecil), L2 (sedikit lebih lambat, kapasitas menengah), dan L3 (lebih lambat, kapasitas lebih besar). Dengan hirarki ini, CPU dapat mengakses data dengan latensi serendah mungkin.

Prinsip kerja cache didasarkan pada dua konsep utama: temporal locality (instruksi atau data yang baru diakses cenderung diakses lagi dalam waktu dekat) dan spatial locality (data yang berdekatan di memori kemungkinan akan diakses bersama). Ketika CPU memerlukan data, pertama-tama ia mencari di L1 cache; jika tidak ditemukan (cache miss), pencarian dilanjutkan ke L2, L3, lalu RAM. Semakin sering data berada di cache (tinggi cache hit rate), semakin cepat CPU dapat mengeksekusi perintah.

Selain itu, strategi write-back dan write-through menentukan bagaimana penulisan data di-cache dipertahankan. Pada write-back, penulisan yang terjadi di cache hanya tersinkronisasi ke RAM saat slot cache perlu diisi ulang, mengurangi traffic ke memori utama. Pada write-through, setiap penulisan langsung diteruskan ke RAM, menjaga data lebih konsisten namun meningkatkan latency. Pemilihan strategi ini bergantung pada beban kerja dan desain arsitektur untuk memaksimalkan efisiensi eksekusi perintah.

Pentingnya ALU dalam Operasi Matematika Komputer

Arithmetic Logic Unit (ALU) adalah bagian dari CPU yang bertugas melakukan operasi aritmetika (penjumlahan, pengurangan, perkalian, pembagian) dan operasi logika (AND, OR, NOT, XOR). Setiap instruksi yang melibatkan perhitungan, baik sederhana maupun kompleks, diproses oleh ALU. Misalnya, ketika Anda melakukan operasi spreadsheet atau memproses grafik 3D, ALU bekerja di balik layar untuk menghitung jutaan operasi per detik.

ALU modern juga dilengkapi Floating Point Unit (FPU) untuk menangani perhitungan pecahan dengan akurasi tinggi. FPU penting dalam aplikasi ilmiah, rekayasa, dan multimedia di mana presisi perhitungan mempengaruhi hasil akhir. Selain itu, CPU dengan multiple ALU dalam satu inti dapat menjalankan beberapa instruksi aritmetika secara paralel, meningkatkan Throughput instruksi per clock cycle (IPC).

Efisiensi ALU selain bergantung pada kecepatan clock juga dipengaruhi pipeline internal, ukuran word (bit width), dan kemampuan SIMD (Single Instruction, Multiple Data). SIMD memungkinkan satu instruksi melakukan operasi sama pada banyak data sekaligus, misalnya pada pemrosesan vektor multimedia atau machine learning. Kombinasi komponen ini menjawab pertanyaan tentang Bagaimana komputer membaca dan mengeksekusi perintah? dengan memastikan operasi matematika dan logika berlangsung cepat dan akurat.

Strategi Pipelining untuk Meningkatkan Efisiensi Eksekusi

Pipelining adalah teknik mempercepat eksekusi instruksi dengan membagi siklus fetch-decode-execute menjadi beberapa tahap yang dapat berjalan bersamaan. Bayangkan jalur perakitan di pabrik: setiap bagian instruksi diproses di stasiun berbeda, sehingga beberapa instruksi bisa berada di berbagai tahap pipeline sekaligus. Ketika satu instruksi sedang dieksekusi, instruksi berikutnya sudah masuk tahap decode, dan instruksi ketiga dalam tahap fetch.

Dengan pipeline, instruksi baru dapat mulai setiap clock cycle, bukan menunggu eksekusi instruksi sebelumnya selesai sepenuhnya. Desain CPU modern memiliki 5–20+ tahap pipeline, tergantung arsitektur. Namun, pipelining membawa tantangan seperti hazard: data hazard (ketergantungan data antar instruksi), control hazard (percabangan), dan structural hazard (konten sumber daya terbatas). Penggunaan forwarding, stall, dan prediksi percabangan membantu mengurangi efek negatif ini, sehingga throughput tetap tinggi.

Strategi pipelining memungkinkan CPU menjawab Bagaimana komputer membaca dan mengeksekusi perintah? dengan memaksimalkan pemanfaatan setiap siklus jam. Dengan meminimalkan waktu idle per komponen dan menjaga aliran instruksi tetap padat, CPU dapat mengeksekusi jutaan instruksi per detik secara berurutan dan paralel.

Pengoptimalan Instruksi dan Prediksi Percabangan

Kompleksitas program modern sering kali melibatkan percabangan (branching) seperti if-else atau loop. Ketika CPU menemui instruksi percabangan, ia harus memilih jalur instruksi selanjutnya. Jika prediksi salah, pipeline harus dibersihkan (flush) dan diisi ulang, menimbulkan penalti waktu. Untuk meminimalkan hal ini, CPU menggunakan branch predictor—sebuah mekanisme yang memprediksi jalur mana yang kemungkinan besar diambil berdasarkan sejarah percabangan.

Branch predictor modern mencakup teknik statis (misalnya selalu prediksi tak diambil) dan dinamis (menggunakan Branch History Table dan Branch Target Buffer). Saat prediksi tepat, CPU tidak membuang siklus; saat salah, overhead misprediksi biasanya beberapa siklus clock. Selain itu, compiler juga berperan mengoptimalkan tata letak kode—mengelompokkan instruksi yang sering dieksekusi bersama, meminimalkan percabangan, dan menyisipkan hint prediksi ke binary akhir.

Optimalisasi instruksi lainnya melibatkan loop unrolling, inlining fungsi, dan dead code elimination. Loop unrolling menggandakan tubuh loop untuk mengurangi jumlah percabangan, sedangkan inlining menghilangkan overhead panggilan fungsi. Dead code elimination menghapus instruksi yang tidak pernah dipakai. Gabungan teknik hardware (branch prediction) dan software (compiler optimization) inilah yang membuat sistem komputer sangat efisien dalam menjalankan alur instruksi kompleks.

Faktor-faktor Eksternal yang Memengaruhi Kecepatan Eksekusi

Meski komponen internal sangat menentukan kinerja, faktor eksternal juga memengaruhi kecepatan eksekusi perintah. Suhu operasi yang tinggi dapat memaksa CPU menurunkan clock (thermal throttling) untuk mencegah kerusakan, sehingga kinerja turun. Sistem pendingin (fan, heatsink, liquid cooling) dan desain aliran udara casing komputer sangat krusial menjaga suhu ideal.

Konektivitas I/O—seperti kecepatan bus PCIe, bandwidth memori, dan protokol penyimpanan (SATA vs NVMe)—mempengaruhi seberapa cepat data dapat dipindahkan antar komponen. Misalnya, SSD NVMe jauh lebih cepat daripada HDD SATA, mengurangi bottleneck saat membaca/menyimpan data besar. Selain itu, beban kerja multi-user pada server, virtualisasi, dan overhead sistem operasi (scheduling, interrupt handling) turut memengaruhi waktu respons aplikasi.

Power management juga berperan: mode hemat daya akan menurunkan frekuensi clock dan voltase CPU, sedangkan performance mode memaksimalkan frekuensi dengan konsumsi daya lebih tinggi. Pengaturan profil daya di BIOS atau OS dapat mengubah bagaimana komputer mengeksekusi perintah sesuai kebutuhan pengguna—apakah mengutamakan hemat energi atau performa maksimal.

Kesimpulan: Komputer Membaca dan Mengeksekusi Perintah dengan Cepat

Secara keseluruhan, kecepatan luar biasa dalam mengeksekusi perintah bukanlah hasil satu komponen saja, melainkan sinergi CPU, memori, cache, ALU, dan teknik optimalisasi seperti pipelining serta prediksi percabangan. Tiap elemen bekerja serentak dalam siklus fetch-decode-execute yang diulang miliaran kali per detik.

Dengan memahami “Bagaimana komputer membaca dan mengeksekusi perintah?”, kita menyadari betapa kompleksnya arsitektur dan algoritma di balik layar. Dari pengkodean biner hingga manajemen suhu, setiap detail dirancang untuk memastikan respons cepat dan akurat, memungkinkan komputer memenuhi beragam kebutuhan modern dengan efisiensi tinggi.

Recent Comments